La Vigilancia Algorítmica y el Poder Opaco de las Big Tech.

En septiembre de 2025, YouTube reconoció públicamente que durante los años previos a las elecciones en Estados Unidos, eliminó contenido relacionado con la pandemia de COVID-19 y la integridad electoral, en respuesta a presiones ejercidas por la administración de Joe Biden. Esta admisión no es un caso aislado. En 2021, Mark Zuckerberg, CEO de Meta, también confirmó que el gobierno estadounidense presionó a su compañía para retirar publicaciones sobre el manejo de la pandemia en Facebook e Instagram.

Ambos casos revelan una práctica preocupante: la censura indirecta ejercida por gobiernos a través de plataformas privadas. Aunque estas empresas afirman actuar en defensa de la salud pública o la integridad democrática, el hecho de que cedan ante presiones políticas plantea serias dudas sobre la libertad de expresión y la transparencia en el ecosistema digital. Mientras estos ejemplos provienen de EE. UU., la dinámica es global. En Latinoamérica, donde la penetración de redes sociales es altísima y la confianza en medios tradicionales es baja, este poder indirecto tiene el potencial de ser aún más desestabilizador en contextos electorales o de crisis social.

Censura Indirecta: La Evolución del Control de la Narrativa en la Era Digital

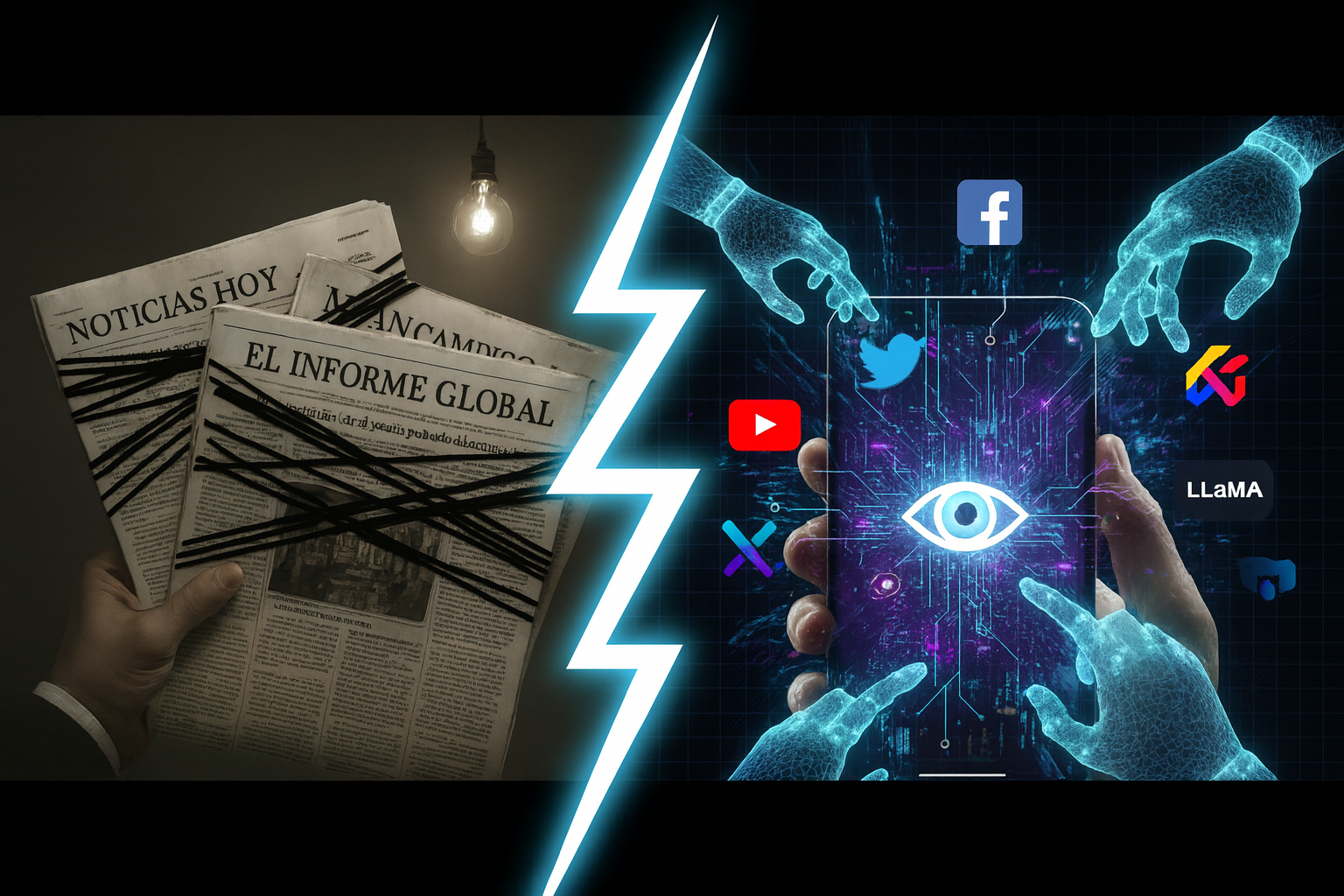

La censura no es nueva. Desde los regímenes autoritarios del siglo XX hasta las democracias modernas, los gobiernos han buscado controlar la narrativa pública. Lo que ha cambiado es el canal. Antes, los medios tradicionales —televisión, radio, prensa escrita— eran los principales vehículos de información. Su alcance era limitado y el consumo, pasivo. Hoy, las redes sociales han transformado ese paradigma: el contenido se consume de forma activa, constante y personalizada.

Este cambio ha multiplicado el impacto de la información. Según estudios del Pew Research Center, más del 70% de los adultos en EE.UU. usan redes sociales como fuente principal de noticias. Y no solo eso: el algoritmo decide qué vemos, cuándo lo vemos y cómo lo interpretamos. A mayor recurrencia en el uso, mayor es el impacto en la forma de pensar, en la percepción de la realidad y en la toma de decisiones políticas.

Vigilancia Algorítmica: Cómo la IA Modela (y Vende) Nuestro Comportamiento Digital

Las redes sociales se presentan como aplicaciones gratuitas, pero en realidad, si no pagas por el producto, es porque tú eres el producto. Cada interacción —un “me gusta”, un comentario, una visualización— se convierte en un dato. Estos datos alimentan complejos sistemas de inteligencia artificial que no solo predicen comportamientos, sino que los moldean.

Estas plataformas son, en esencia, gigantescos centros de datos. Recogen patrones de consumo, emociones, preferencias ideológicas, hábitos de compra y relaciones interpersonales. Este insumo es ideal para entrenar modelos de IA que luego se aplican en publicidad, predicción de tendencias, manipulación de contenidos y, en última instancia, influencia política.

Las Big Tech y la Minería de Datos: El Entrenamiento Estratégico de sus Modelos de IA

No es casualidad que las grandes tecnológicas estén desarrollando sus propios modelos de inteligencia artificial. YouTube, propiedad de Google, ha integrado Gemini; Meta trabaja con LLaMA; X (antes Twitter), bajo el mando de Elon Musk, ha lanzado Grok. Estos modelos no solo responden preguntas o generan contenido: están entrenados con los datos de millones de usuarios.

La compra de Twitter por parte de Musk, a un precio superior al valor de mercado, fue vista por muchos como una jugada estratégica. Más allá de la red social, Musk adquirió una mina de datos para entrenar sus modelos de IA. En sus propias palabras, “X es una fuente invaluable para entender el lenguaje humano en tiempo real”.

Ética de la IA: Opacidad, Sesgos y la Trazabilidad en el Entrenamiento de Modelos

Aquí surge una cuestión ética fundamental: ¿quién entrena a la IA y con qué valores? En 2023, Meta enfrentó críticas por prácticas cuestionables en el entrenamiento de sus modelos. Se filtraron documentos que revelaban que algunos comandos utilizados por entrenadores humanos incluían contenido inapropiado.

Otros casos similares han surgido en empresas como OpenAI y Google, donde se ha cuestionado la opacidad en los procesos de entrenamiento y la selección de datos. El peligro no es solo la opacidad, sino que los modelos de IA replican y amplifican los sesgos presentes en la data de entrenamiento, sea esta inapropiada o simplemente limitada culturalmente. Esto significa que las decisiones mediadas por IA —desde la moderación de contenido hasta la aprobación de créditos— están construyendo un futuro digital con los prejuicios del pasado. En un mundo donde la IA comienza a mediar nuestras búsquedas, decisiones laborales y relaciones sociales, la ética en su desarrollo no puede ser una nota al pie.

El Futuro Inevitable: ¿Estamos Cediendo Nuestra Autonomía Cognitiva a la IA?

Vivimos en una era donde las redes sociales no solo informan, sino que configuran la realidad. La censura, la manipulación algorítmica y el entrenamiento de modelos de IA con datos personales son prácticas que redefinen el poder. Ya no se trata solo de gobiernos o corporaciones: se trata de sistemas que aprenden, predicen y actúan sobre nosotros sin que lo sepamos.

La pregunta que debemos hacernos no es si estas prácticas son legales, sino si son legítimas. ¿Estamos dispuestos a ceder nuestra autonomía cognitiva a plataformas que responden a intereses políticos o comerciales? ¿Qué mecanismos de control y transparencia exigimos como ciudadanos digitales?

Alfabetización Algorítmica: Conciencia Ciudadana y Transparencia contra el Poder de la IA

La censura digital, la manipulación algorítmica y el uso de datos para entrenar inteligencia artificial son tres caras de una misma moneda: el poder en la era de la información. Lo que antes se hacía con imprentas y micrófonos, hoy se hace con servidores y modelos de lenguaje. Y aunque las herramientas han cambiado, el objetivo sigue siendo el mismo: controlar lo que pensamos, decimos y hacemos.

Es imposible hoy desconectarse de las redes sociales o evitar el uso de inteligencia artificial. Forman parte de nuestra vida cotidiana, de nuestras decisiones laborales, sociales y personales. La solución no es la desconexión total, sino la alfabetización algorítmica y la exigencia cívica. Como ciudadanos digitales, debemos demandar auditorías externas a los algoritmos y transparencia radical en el entrenamiento de la IA. Son herramientas moldeadas por intereses, algoritmos y datos. Y como toda herramienta, deben ser usadas con criterio, con conciencia y con responsabilidad. Porque en un mundo donde el producto eres tú, el poder de decidir debe seguir siendo tuyo. (O)

Este artículo representa una opinión personal y no refleja la postura oficial de este medio. Se trata de un análisis basado en fuentes y percepciones del autor sobre el contexto actual tecnológico y social.